Esperanto Zeitungsausschnitte

Das CLARIAH-AT Projekt Esperanto Newspaper Excerpts (Esperanto Zeitungsausschnitte) hatte die Erstellung von Volltexten zu Zeitungsausschnitten aus der Sammlung Hachette zum Ziel. Dabei handelt es sich um eine Sammlung von etwa 17.000 Zeitungsartikeln über Esperanto aus der Zeit von 1898 bis 1915, die in der Sammlung für Plansprachen an der Österreichischen Nationalbibliothek (ÖNB) aufbewahrt werden. In diesem Topic möchten wir die Ausgangslage, den Verlauf und die Ergebnisse des einjährigen Forschungsprojekts vorstellen.

Inhalt:

1. Ausgangslage und Motivation

Die Sammlung für Plansprachen an der Österreichischen Nationalbibliothek – hervorgegangen aus dem 1927 gegründeten Esperantomuseum – verfügt über umfangreiche Bestände zu Esperanto und anderen Plansprachen. Als Plansprachen bezeichnet man nach gewissen Kriterien bewusst geschaffene Sprachen. Diese werden in der Interlinguistik, einem Zweig der Sprachwissenschaft, erforscht.

Die Sammlung Hachette

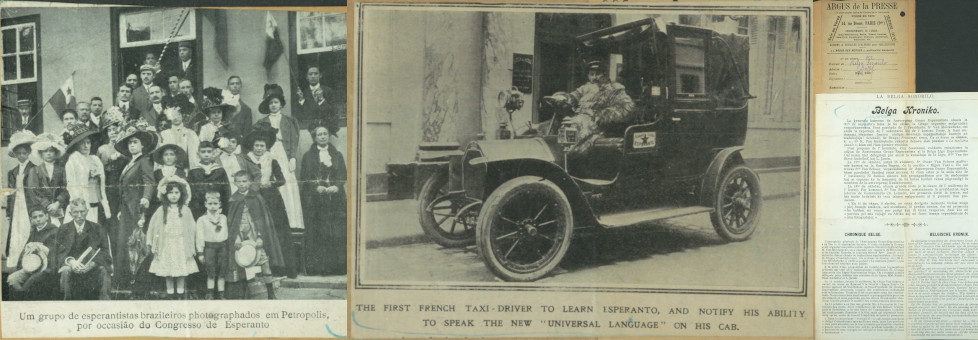

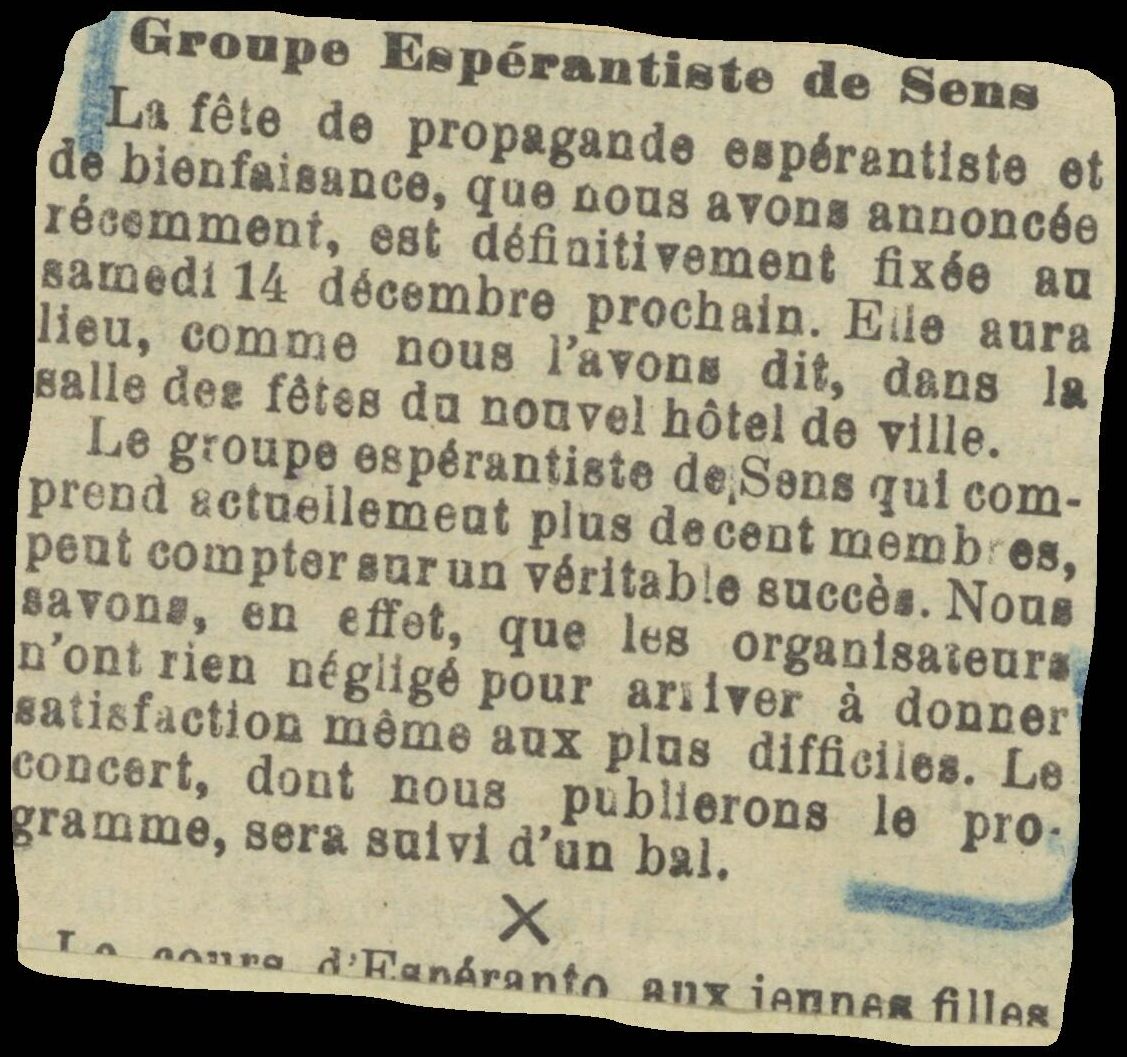

Die Sammlung von Zeitungsausschnitten, die in diesem Projekt bearbeitet wurde, besteht aus etwa 17.000 Artikeln, die aus Zeitschriften stammen, welche in vielen verschiedenen europäischen Ländern im Zeitraum von 1898 bis 1915 veröffentlicht wurden. Die Artikel selbst berichten von Ereignissen und Personen, die mit Esperanto in Verbindung stehen, z.B. Berichte von Esperanto-Weltkongressen, und bieten daher eine hervorragende und einzigartige Gelegenheit, die Geschichte der Esperanto-Bewegung in Europa im frühen 20. Jahrhundert zu untersuchen.Zusätzlich zu den an der ÖNB erstellten Digitalisaten für jeden Zeitungsartikel gibt es bereits Metadaten, die von Mitarbeiter*innen der Sammlung für Plansprachen erzeugt wurden. Dabei handelt es sich um Angaben zu Titel, Autor, Zeitschrift, Veröffentlichungsdatum, Ort und Sprache (sowie in manchen Fällen Schlagwörter) für jeden Zeitungsartikel.

Forschungsfragen

Unter Interlinguisten besteht ein großes Interesse an dieser Zeit und Sammlung (z. B. von Forscher*innen in Princeton, St. Andrews, Berlin und Wien). In der Sammlung gibt es einen besonders interessanten Teil: Die 6.632 Artikel, die in französischen Zeitungen veröffentlicht wurden, sind in ihrer (fast) vollständigen Abdeckung umfangreich. Da die Artikel der Sammlung chronologisch und nach Erscheinungsort sortiert sind, ist es möglich, diesen Teil aus dem größeren Set zu extrahieren. Dann ist es möglich Forschungsfragen zu Namen von Personen, Orten, Vereinen und weiteren Entitäten mithilfe der Volltexte der Zeitungsartikel zu beantworten.

Als Ergebnis des Projekts wird diese wichtige Esperanto-Artikelsammlung durchsuchbar, was für die Forschungsgemeinschaft und alle, die sich für Esperanto und diese Zeit im Besonderen interessieren, von großem Wert ist. Wir werden die Sammlung für weitere Forschungen öffnen, da der Text für die Analyse mit digitalen Methoden (NLP, NER, TF/IDF usw.) zugänglich wird. Schließlich wird die Sammlung ergänzt, indem wir von einfachen Bildern zu Bildern mit Textdateien und Metadaten an einem Ort übergehen.

Antragstellung und Förderschiene

Zum Zeitpunkt unserer Planung wurden wir auf das Förderungsausschreiben 2022 („Interoperabilität und Wiederverwendbarkeit von DH-Daten und Werkzeugen“) des CLARIAH-AT-Konsortiums aufmerksam, welches zum Ziel hatte, die Förderung der Interoperabilität und Wiederverwendbarkeit von Werkzeugen, Methoden und Forschungsinfrastrukturen im Einklang mit der Digital Humanities Austria Strategie 2021+ sowie den strategischen Zielen der Infrastrukturkonsortien CLARIN ERIC und DARIAH-EU zu unterstützen.

Wir fanden, dass unsere Projektidee sehr gut auf diese Ausschreibung gepasst hat und haben dementsprechend unseren Antrag geschrieben und eingereicht. Zu unserer großen Freude wurde dieser angenommen und somit das Projekt für ein Jahr mit einer halben Entwicklerstelle unterstützt.

2. Pipeline und verwendete Technologien

Übersicht der Pipeline

Im Projekt wurde eine Pipeline entwickelt, mit der Volltexte aus den Originalbildern extrahiert werden konnten. Grob gesagt besteht diese Pipeline aus vier Schritten:

- Segmentierung der zu einem Artikel gehörenden Bilder in einzelne Textboxen

- Drehen der ermittelten Boxen, so dass der Text waagrecht steht

- Anwendung von Tesseract auf jede Box für die Texterkennung

- Erzeugen eines IIIF Manifests pro Artikel aus den generierten ALTO-XML-Dateien

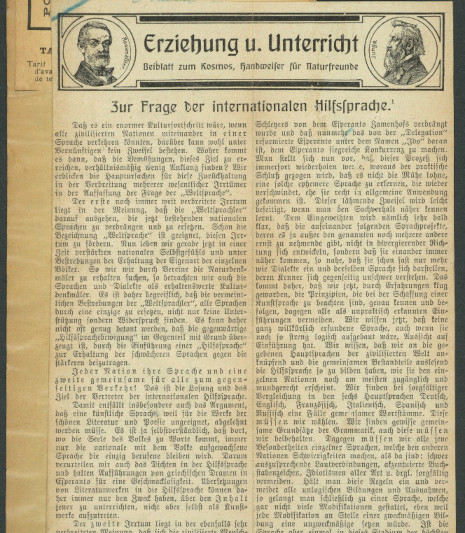

Segmentierung der Artikel mit YOLOv8

Für die Aufgabe der Layoutanalyse verwenden wir das YOLOv8-Modell (siehe hier für mehr Informationen), welches ein leistungsstarkes Modell für übliche Aufgaben wie Objekterkennung, Bildklassifizierung und -segmentierung ist. Um die Qualität der Layouterkennung zu verbessern wurde ein fine-tuning durchgeführt mit manuell erstellten annotierten Bildern. Danach wurde das Modell auf alle 22.247 Bilder im Datensatz angewendet und alle mit „Text“ annotierten Bereiche an die nächste Stufe weitergereicht. Siehe Abb. 1 für eine visuelle Darstellung der in diesem Schritt erzeugten Daten.

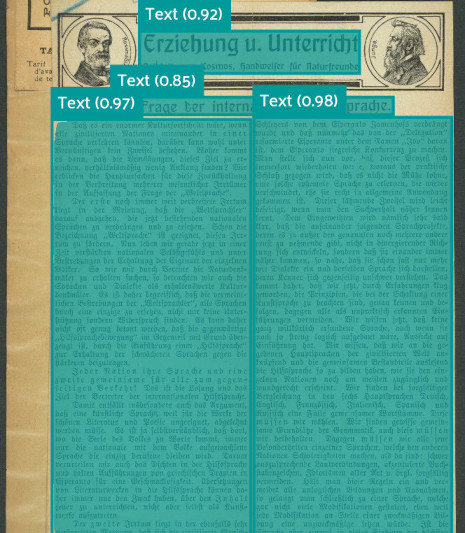

Geradedrehen der Textboxen

Ein sehr typisches Problem bei den Zeitungsausschnitten dieser Sammlung ist, dass die Ausschnitte nicht parallel zu den Kanten des Kartons aufgeklebt wurden (und teilweise auch mehrere Ausschnitte auf einem Karton sind, die gegeneinander verdreht sind). Die Qualität der mit typischer OCR-Software generierten Volltexte nimmt allerdings stark ab, wenn die Eingabetexte nicht waagrecht sind. Daher haben wir auf Basis der offenen Programmbibliothek OpenCV ein Python-Skript entwickelt, welches die Richtung (bzw. den Winkel) eines Textblocks detektiert und im Anschluss das Bild um diesen Winkel zurückdreht. Siehe Abbildung 2 für eine Demonstration der Anwendung des Skripts auf zwei Beispielbilder.

Texterkennung mittels Tesseract

Für die Texterkennung haben wir die offene Software Tesseract OCR verwendet, da Esperanto und weitere Sprachen im Datenset direkt unterstützt werden. Ansonsten hätten noch manuell Groundtruth-Texte in Esperanto erstellt werden müssen für ein Training der OCR-Software. Der Aufruf von Tesseract erfolgt mit den folgenden Einstellungen:

langs = 'fra+deu+Fraktur+frk+eng+spa+ita+epo+rus+nld+por+pol+ces+cat+swe+dan+hun+lat+bul+fin+isl+ron'tesseract -l {langs} --oem 1 --psm 1 {deskewed_path} {ocr_path}-deskewed.alto alto txt

Dabei steht deskewed_path für den Dateipfad des im zweiten Schritt erzeugten Bilds mit geradem Text und ocr_path für den Zielort der zu erzeugenden Textdaten. So haben wir für jede Textbox eine ALTO-XML-Datei erzeugt.

Erzeugen von IIIF Manifesten aus ALTO-XML-Dateien

Im vierten und letzten Schritt werden die zu allen Textboxen auf einer Seite gehörigen ALTO-XML-Dateien zu einer einzigen ALTO-XML-Datei vereint und diese wiederum in IIIF-konforme Annotationen umgewandelt. Für jeden Artikel wird dann ein IIIF Manifest erzeugt mit einem bis mehreren Bildern, die jeweils besagte Text-Annotationen tragen.

3. Ergebnisse

Einträge im Katalog der ÖNB

Die zuvor erwähnten Metadaten wurden im Rahmen des Projekts nun auch in das Katalogssystem der ÖNB integriert und können dort über den Suchbegriff „Sammlung Hachette“ gefunden werden. Dies erlaubt auch die Recherche mit den üblichen Filtermethoden des Katalogs und beinhaltet insbesondere den Verweis auf die entsprechenden Digitalisate.

Solr-Volltextsuche

Das Hauptziel des Projekts war es, die Volltexte der Zeitungsartikel durchsuchbar zu machen. Dies haben wir mithilfe von Solr realisiert und bieten eine Volltextsuche in diesem Bestand über die ÖNB Labs als ein Tool an. Tatsächlich erlaubt die gewählte Umsetzung die kombinierte Suche in allen Metadaten (Titel, Autor, Zeitschrift, Datum, Ort, Sprache, Schlagwörter) sowie den Volltexten inklusive der bei Solr üblichen Ähnlichkeitssuche.

Datenset

Die im Projekt erzeugten Daten werden von uns gebündelt als Datenset hier angeboten. Zusätzlich zu den Projektergebnissen als Download können dort weitere Informationen zum Umfang und Inhalt des Datensets abgerufen werden. Zusätzlich finden sich Rechteinformationen, ein Zitiervorschlag und die Möglichkeit im Datenset zu stöbern.

IIIF Manifeste

Ganz im Sinne der Interoperabilität und Wiederverwendbarkeit, welche in der Förderausschreibung gewünscht war, haben wir eine IIIF Collection erzeugt, welche alle im Projekt generierten IIIF Manifeste enthält und somit Zugriff auf alle Bilder, Metadaten und Volltexte erlaubt. Diese Collection ist hier zu finden.

4. Links und Fördergeber

Dieses Projekt wurde unterstützt durch CLARIAH-AT. Die Webseite des Projekts beim Fördergeber ist hier zu finden.

Mitmachen

Der Quellcode, sowie der Trainingsdatensatz und das erzeugte Modell zur Layoutanalyse sind im Gitlab Repository des Projekts zu finden.